Foto: Lietzmann

Foto: Lietzmann

Beim runderneuerten Logistikkongress in Berlin (wäre «Supply Chain» kein Allgemeinbegriff, könnte der Zusatz als «CX» auch von der Nähe zur Schweiz künden) wird seit Jahren nicht nur ein «Logistik-», sondern auch ein Wissenschaftspreis verliehen. Diesmal für ein KI-gestütztes «Reinforcement Learning».

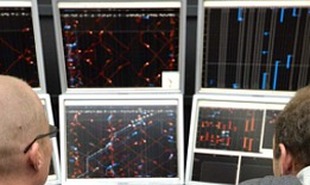

Nach einer Präsentation der vier Finalisten auf der «Deep Dive Stage» der BVL Supply Chain CX kürte die Jury eine Dissertation von Sebastian Lang zur Künstlichen Intelligenz im Hinblick auf ein konkretes praktisches Anwendungsfeld, nämlich die Berechnung von Produktions-Ablaufplänen, zum Siegerprojekt. Dabei nutzt Lang Methoden eines so genannten «Reinforcement Learning» (RL), also des bestärkenden Lernens. Das erlaubt es, eine Software mittels Trial-and-Error so zu trainieren, dass diese im Anschluss Produktionsablauf-Entscheidungen in Echtzeit berechnen kann.

Der Unterschied zu etablierten Verfahren ist, dass nicht nach Trainingslabeln, sondern durch Versuch und Irrtum trainiert wird. Was ein wenig nach altbekannten Programmierschritten «If – then – go to» klingt. Aus dem positiven wie negativen Feedback sollen Anwendungen des «Reinforcement Learning» allerdings langfristig und mit wesentlich höherer Wahrscheinlichkeit die richtigen Schlüsse ziehen und Schritt für Schritt eine deutlich zuverlässigere Planungs- und Steuerungsstrategie entwickeln, als es mit herkömmlichen Systemen möglich wäre. Damit betrat Lang Neuland: In den letzten 30 Jahren gab es nur rund 100 Veröffentlichungen zu RL. Das bestärkende Lernen eigne sich im besonderen Masse für die sehr anspruchsvolle Ablaufplanung in hochvolatilen, komplexen oder störanfälligen Produktionsumgebungen. Die Dissertation von Lang zeigt anhand eines konkreten Beispiels aus der Transportplanung auf, dass das Konzept auch auf andere Bereiche der Logistik übertragbar sein dürfte.

- Details

- Geschrieben von: Klaus Koch